Рабочая лошадка

Несколько месяцев назад ChatGPT и другие чат-боты на основе больших языковых моделей (Large Language Models, LLM) были в новинку. Пользователи развлекались, сочиняя с их помощью стихи и тексты песен в стиле известных исполнителей (которые Ник Кейв, например, совершенно не оценил), исследователи рассуждали, не стоит ли начать взрывать дата-центры, пока супер-ИИ не устроил армагеддон, а специалисты по безопасности уговаривали упрямого чат-бота дать им инструкции по прослушиванию телефонов и угону автомобилей.

Сейчас ChatGPT стал для многих незаменимым помощником в повышении продуктивности на работе. Случаи недоступности сервиса широко освещаются в СМИ, а пользователи при сбоях жалуются в социальных сетях, что им снова приходится использовать мозг. Технология становится привычной, и ее неспособность поспевать за растущими запросами людей приводит к жалобам, что чат-бот со временем глупеет. Если посмотреть на график популярности запроса ChatGPT в Google-трендах, то можно заключить с некоторой степенью уверенности, что люди в первую очередь обращаются за помощью к чат-боту по будням, то есть, вероятнее всего, по рабочим вопросам.

Динамика популярности запроса «ChatGPT», 01.04.2023–30.09.2023, источник: GoogleTrends; данные выгружены 6.10.2023 (скачать)

То, что чат-боты активно используют в рабочих целях, подтверждается данными исследований. Согласно опросу «Лаборатории Касперского», проведенному среди россиян, 11% респондентов пользовались или пользуются чат-ботами и почти 30% уверены, что в будущем они многих лишат работы. Еще два наших исследования показали, что в Бельгии к ChatGPT обращаются 50% офисных работников, а в Великобритании — 65%. Среди последних 58% используют чат-бота для экономии времени — например, для написания кратких протоколов собраний, выделения главной мысли в тексте и т. д., 56% — для написания новых текстов, улучшения стиля и грамматики, а также для перевода, 35% — для аналитики, например изучения трендов. Тех, кто пишет код с помощью ChatGPT, оказалось 16%.

Так или иначе, тот факт, что чат-боты активно используются в бизнесе, поднимает вопрос: насколько безопасно доверять им корпоративные данные? В этой статье мы проанализировали настройки и политики приватности чат-ботов, основанных на больших языковых моделях, чтобы понять, как они собирают и хранят информацию о переписках и как офисные сотрудники, пользуясь ими, могут защитить или подвергнуть опасности данные компаний и клиентов.

Возможные угрозы конфиденциальности

Большинство чат-ботов на основе LLM: ChatGPT, Microsoft Bing Chat, Google Bard, Anthropic Claude и другие — это облачные сервисы. Пользователь создает аккаунт и таким образом получает доступ к боту. Нейросеть, будучи огромной ресурсоемкой системой, запускается на стороне провайдера — следовательно, владелец сервиса имеет доступ к переписке пользователя с чат-ботом. Более того, многие сервисы позволяют сохранять историю чатов на сервере, чтобы пользователь мог к ним позже вернуться.

При этом в уже упомянутом выше исследовании в Великобритании 11% респондентов, использующих ChatGPT на работе, заявили, что делились с чат-ботом внутренними документами или корпоративными данными и не считают, что это неправильно. Еще 17% заявили, что хотя это и кажется им рискованным, они все равно использовали в разговоре с чат-ботом закрытую корпоративную информацию.

Учитывая чувствительность данных, которыми пользователи обмениваются с чат-ботами, стоит определиться с возможными угрозами конфиденциальности этих данных. В случае с большими языковыми моделями информация, переданная боту, может быть скомпрометирована в нескольких сценариях:

- Утечка данных со стороны провайдера или взлом. Хотя операторы больших чат-ботов — крупные компании с заслуженной репутацией, они могут теоретически стать жертвой взлома или непреднамеренной утечки. Например, в марте произошел инцидент, в результате которого пользователи ChatGPT могли видеть некоторые сообщения из чатов других пользователей.

- Утечка данных через чат-бота. Теоретически переписка пользователей с чат-ботом может в дальнейшем попасть в корпус данных для обучения следующих версий модели. Учитывая, что большие языковые модели подвержены так называемому непреднамеренному запоминанию — то есть заучиванию уникальных последовательностей вроде номеров телефонов, которые не улучшают качество модели, но создают риски конфиденциальности — данные, попавшие в обучающий корпус, могут затем быть случайно или намеренно извлечены из модели другими пользователями.

- Недобросовестный сервис. Это особенно касается стран, где официальные сервисы вроде ChatGPT заблокированы и пользователи обращаются к ним через неофициальные клиенты в виде программ, веб-сайтов и ботов в мессенджерах. Посредник при этом может сохранять всю историю переписок и оставлять за собой право использовать их в своих целях, а сам клиент может и вовсе оказаться зловредным.

- Взлом аккаунта. Наконец, важной проблемой является безопасность учетных записей. Даже если сотрудник пользуется только официальным клиентом, безопасность переписок, потенциально содержащих конфиденциальную информацию, часто остается на совести его владельца, равно как и то, какая именно информация попадает в диалог с чат-ботом. Злоумышленники вполне могут получить доступ к аккаунтам сотрудников — и данным в них, — например, через фишинговые атаки или credential stuffing.

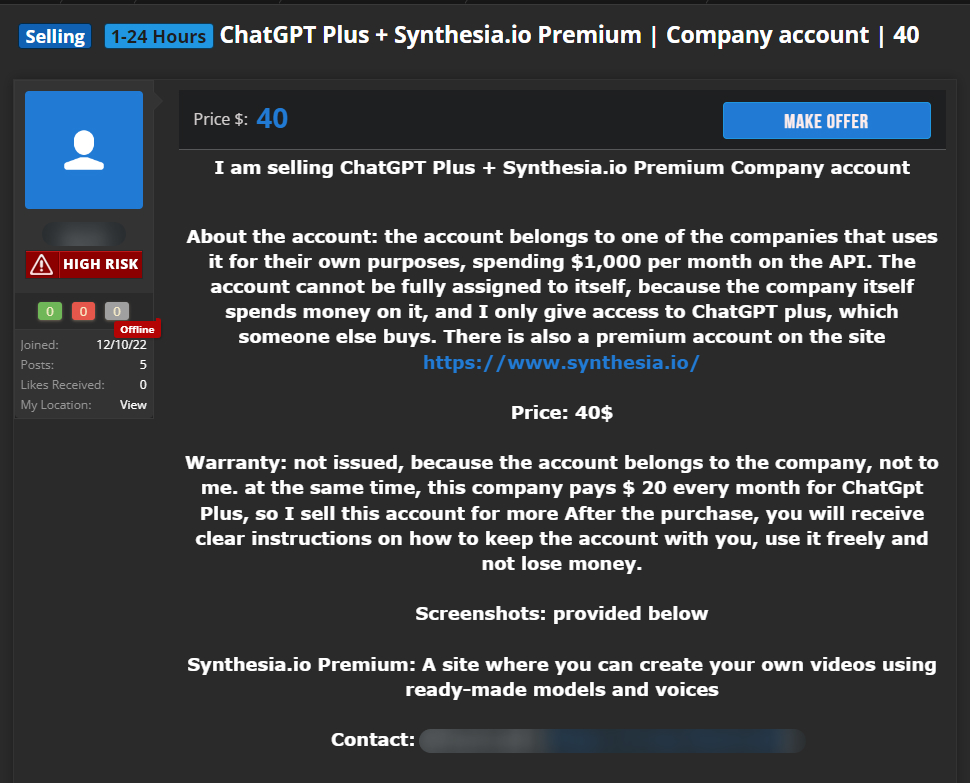

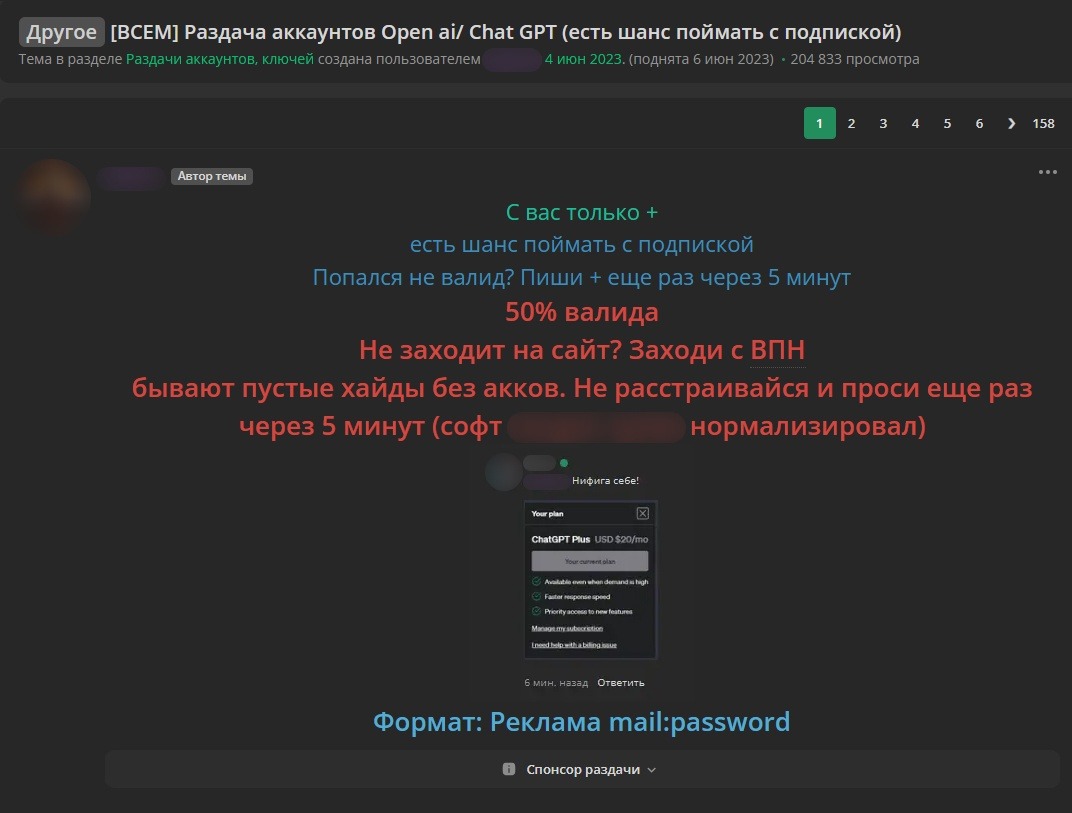

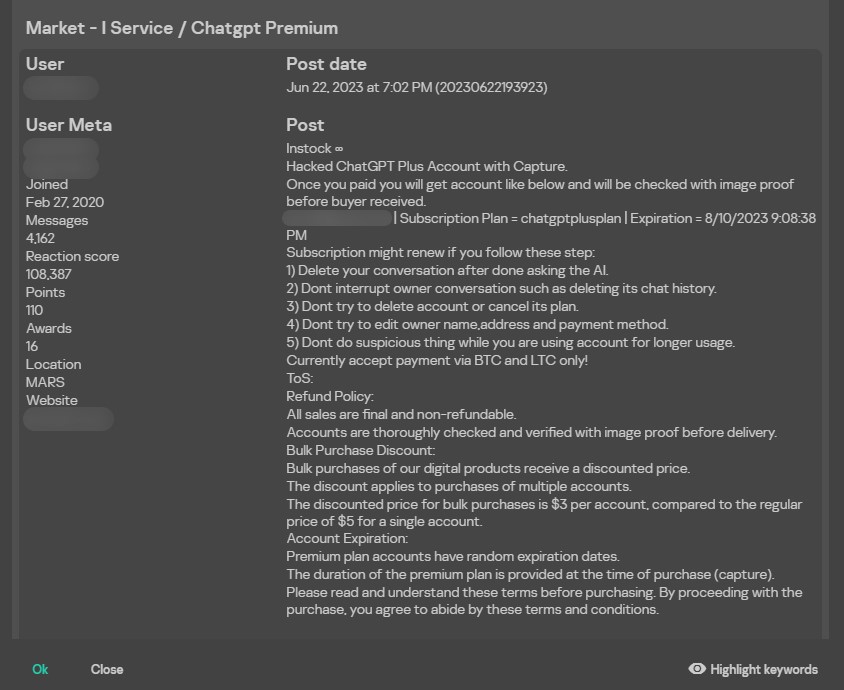

Угроза взлома аккаунта не гипотетическая. Эксперты Kaspersky Digital Footprint Intelligence регулярно обнаруживают на закрытых форумах (в том числе в даркнете) посты о продаже доступа к аккаунтам в чат-ботах:

На скриншоте сверху сообщается о продаже за 40 долларов корпоративного аккаунта компании, которая оплачивает подписку на ChatGPT и доступ к API. Иногда злоумышленники продают аккаунты дешевле или даже раздают бесплатно, но без гарантий наличия в учетной записи активной подписки:

Покупателям взломщики дают инструкции, как пользоваться взломанным аккаунтом: например, рекомендуют не трогать чаты его владельцев и удалять свои переписки сразу после общения с чат-ботом.

В результате такой покупки злоумышленник получает бесплатный доступ не только к оплаченному ресурсу, но и ко всем чатам взломанной учетной записи.

Вопросы конфиденциальности данных вызывают беспокойство у компаний. Так, корпорация Samsung в мае, по сообщениям СМИ, запретила своим сотрудникам пользоваться ChatGPT. В Великобритании, по данным нашего опроса, около одного процента пользователей столкнулись с полным запретом ChatGPT на работе, а две трети компаний уже ввели те или иные правила по использованию генеративного ИИ на рабочем месте, хотя 24% респондентов не считают их достаточно понятными или полными. Чтобы грамотно защитить свой бизнес от угроз конфиденциальности, не отказываясь от чат-ботов как инструмента, необходимо в первую очередь проанализировать риски, актуальные для каждого отдельного сервиса.

Как разные чат-боты обращаются с данными пользователей

Есть одно очень простое, но мало кем выполняемое правило использования любых онлайн-сервисов: перед тем как регистрироваться в очередной новой системе, необходимо хотя бы бегло прочитать ее политику конфиденциальности. Обычно добросовестные сервисы в этом документе не только описывают, какие данные они собирают и как их используют, но и четко прописывают права пользователей в отношении собранных данных. Эту информацию полезно знать каждому, кто решается доверить какие-либо данные очередному сервису.

Для того чтобы понять, насколько верно утверждение, что чат-боты обучаются на затравках (prompts), которые отправляет пользователь, действительно ли они хранят все переписки и насколько опасно использовать таких помощников в работе, мы взяли несколько сервисов популярных чат-ботов на основе больших языковых моделей (ChatGPT, ChatGPT API, Anthropic Claude, Bing Chat, Bing Chat Enterprise, You.com, Google Bard, Genius App от Alloy Studios), проанализировали их политики конфиденциальности и проверили, насколько надежно пользователь может защитить свои аккаунты в каждом из них.

На стороне пользователя: двухфакторная аутентификация и история общения

Среди настроек приватности, доступных пользователю, нас интересовали в первую очередь две вещи:

- хранит ли сервис переписку с чат-ботом непосредственно в аккаунте;

- как пользователь может защитить учетную запись от взлома.

Одной из базовых защит аккаунта в любом онлайн-сервисе является двухфакторная аутентификация (2FA). Если первый фактор в большинстве сервисов — это пароль, то вторым может быть одноразовый код, который отправляется в SMS или на электронную почту или генерируется в специальном приложении, или же куда более сложный механизм, например цифровой ключ на физическом носителе. Наличие двухфакторной аутентификации в сервисе и ее реализация — важный показатель того, насколько вендор заботится о безопасности данных пользователя.

В Bing Chat и Google Bard для того, чтобы пообщаться с чат-ботом, необходимо авторизоваться с помощью аккаунта Google или Microsoft соответственно. Следовательно, безопасность переписки с чат-ботом на стороне пользователя зависит от того, насколько он защитил свои аккаунты в этих глобальных сервисах. Обе корпорации предоставляют все необходимые инструменты для самостоятельной защиты учетных записей от взлома: двухфакторную аутентификацию с возможностью получать второй фактор различными способами (генерировать код в приложении, получать в SMS и т. д.), возможность просматривать историю активности и управлять подключенными к аккаунту устройствами.

Google Bard хранит в аккаунте историю общения, но дает возможность ее настраивать и удалять. На странице со справочной информацией есть инструкция, как это можно сделать. Bing Chat тоже хранит историю общения. На сайте Microsoft Community можно найти ответ на вопрос, как удалить и настроить историю Bing Chat.

При использовании Genius App от Alloy Studios от вас не требуется авторизация в приложении, но получить доступ к истории общения с чат-ботом можно только с устройства с AppleID, на который оформлена подписка. Следовательно, насколько у вас защищен AppleID, настолько защищен и доступ к запросам к чат-боту. В Genius App есть возможность удалить любые затравки прямо в интерфейсе приложения.

ChatGPT от OpenAI предоставляет пользователю выбор: хранить историю переписки и позволять модели обучаться на ней или не хранить и не позволять. Причем это одна настройка. То есть выбрать гибкий вариант, например сохранять чаты, но запретить использовать их для обучения, не получится. Что же касается 2FA в ChatGPT, то на начало нашего исследования эта опция присутствовала в настройках, но спустя некоторое время по какой-то причине возможность защитить аккаунт при помощи двухфакторной аутентификации исчезла.

Для того чтобы авторизоваться на You.com, вам необходимо указать адрес электронной почты, на который придет одноразовый код для входа. Такая же система и у Claude (Anthropic). Никаких других факторов аутентификации в этих сервисах нет, то есть в случае взлома электронной почты злоумышленники легко получат доступ к учетной записи. You.com хранит историю общения с чат-ботом, но с большими оговорками. В интерфейсе чат-бота можно активировать приватный режим. На странице политики конфиденциальности о нем сказано так: Private mode: no data collection. Period («Приватный режим: данные не собираются. Точка»). Claude также хранит историю переписки. На странице support.anthropic.com есть ответ на вопрос, как ее удалить.

На стороне провайдера: обучение модели на затравках и ответах чат-бота

Один из серьезных рисков при использовании чат-ботов — утечка персональных данных в обучающий корпус самого бота. Представьте себе, что вам надо, например, оценить идею нового продукта и вы используете для этого чат-бот, которому предоставляете на входе полное описание идеи для наиболее точной оценки. Если система использует затравки для дообучения, то ваша идея попадает в обучающий корпус и другой человек, который будет интересоваться схожей темой, может получить в ответе полное или частичное описание вашего продукта. Даже если сервис анонимизирует данные перед добавлением в обучающий корпус, это не гарантирует защиту от утечки, поскольку сам вводимый текст имеет интеллектуальную ценность. Именно поэтому перед тем, как начать использовать какой-либо чат-бот, стоит разобраться, обучается ли он на ваших затравках и можно ли этого избежать.

Добросовестные разработчики чат-ботов указывают информацию об использовании данных для обучения модели в политике конфиденциальности. Например, OpenAI использует контент, который предоставляет пользователь, для улучшения сервиса, но при этом дает возможность отказаться от предоставления информации.

As noted above, we may use Content you provide us to improve our Services, for example to train the models that power ChatGPT. See here for instructions on how you can opt out of our use of your Content to train our models.

(«Как отмечено выше, мы можем использовать предоставленный вами контент для улучшения наших сервисов, например для обучения моделей, лежащих в основе ChatGPT. Инструкции, как отказаться от использования вашего контента для обучения моделей, можно найти здесь».)

При этом стоит понимать, что вся переписка с ботом, отправленная до того, как вы в настройках запретили использование ваших данных, попадет в материалы для переобучения моделей. Цитата:

You can switch off training in ChatGPT settings (under Data Controls) to turn off training for any conversations created while training is disabled or you can submit this form. Once you opt out, new conversations will not be used to train our models.

(«Вы можете отключить обучение в настройках ChatGPT (раздел Data Controls), чтобы модель не обучалась на сообщениях, отправленных, пока обучение отключено, или вы можете заполнить эту форму. После того как вы отказались от обучения модели, новые сообщения не будут использоваться для этой цели».)

В отношении бизнеса и пользователей API у OpenAI другие правила. Тут, наоборот, пока пользователь не разрешит модели обучаться на данных, которые он предоставляет, они использоваться не будут.

No. We do not use your ChatGPT Enterprise or API data, inputs, and outputs for training our models.

(«Нет. Мы не используем вашу данные ChatGPT Enterprise и API, входные и выходные данные для обучения наших моделей».)

Похожее отношение к пользовательским данным у Bing Chat и Bing Chat Enterprise. В документе The new Bing: Our approach to responsible AI («Новый Bing: наш ответственный подход к ИИ») указано:

Microsoft also provides its users with robust tools to exercise their rights over their personal data. For data that is collected by the new Bing, including through user queries and prompts, the Microsoft privacy dashboard provides authenticated (signed in) users with tools to exercise their data subject rights, including by providing users with the ability to view, export, and delete stored conversation history.

(«Microsoft предоставляет пользователям надежные инструменты для защиты своих прав по отношению к персональным данным. Авторизованные пользователи могут применять правовые инструменты к данным, собираемым новым Bing, в том числе к пользовательским запросам и затравкам, через панель управления конфиденциальностью (Microsoft privacy dashboard), в частности просматривать, экспортировать и удалять историю сообщений».)

Следовательно, да, Bing Chat собирает и анализирует ваши запросы. По поводу использования данных в документе говорится следующее:

More information about the personal data that Bing collects, how it is used, and how it is stored and deleted is available in the Microsoft Privacy Statement.

(«Больше информации о персональных данных, которые собирает Bing, о том, как они используются, хранятся и удаляются, можно прочитать в Заявлении о конфиденциальности Microsoft»).

По ссылке можно найти список целей сбора данных, одна из которых — «улучшение и разработка наших продуктов», что в случае чат-бота можно интерпретировать как обучение модели.

Что же касается Bing Chat Enterprise, то вот что указано в разделе «Защита и конфиденциальность» (Privacy and protections):

Because Microsoft doesn’t retain prompts and responses, they can’t be used as part of a training set for the underlying large language model.

(«Поскольку Microsoft не сохраняет затравки и ответы, они не могут быть использованы для обучения LLM, лежащей в основе Bing»).

Чат-бот еще одного IT-гиганта, Google Bard, также указывает, что собирает пользовательские запросы для улучшения существующих и обучения новых моделей. На странице Примечания о конфиденциальности Bard прямо говорится:

«Google собирает записи ваших чатов с Bard, отзывы, информацию об использовании продукта и сведения о местоположении. Мы используем эти данные согласно Политике конфиденциальности Google, чтобы предоставлять, улучшать и разрабатывать технологии машинного обучения, а также продукты и сервисы (в том числе корпоративные, например, Google Cloud)».

Чат-бот Claude (Anthropic) тоже собирает данные пользователей, но при этом анонимизирует их. На странице Privacy & Legal («Права и конфиденциальность»), в ответе на вопрос How do you use personal data in model training? («Как вы используете личные данные в обучении моделей?») указано:

We train our models using data from three sources: <…> 3. Data that our users or crowd workers provide.

(«Мы обучаем наши модели на данных из трех источников: <…> 3. Данные, предоставленные нашими пользователями и краудворкерами»).

В этом же документе ниже уточняется:

And before we train on Prompt and Output data, we take reasonable efforts to de-identify it in accordance with data minimization principles.

(«Перед тем как начать обучение на данных затравок и ответов, мы стараемся в разумных пределах обезличить их в соответствии с принципами минимизации данных»).

У You.com, как мы уже упоминали, есть два режима — приватный и стандартный. В приватном режиме, если верить информации в политике конфиденциальности компании, никакие данные не собираются. В стандартном режиме собирается любая информация о взаимодействиях с сервисом. В тексте прямо не говорится о том, что собираются именно ваши затравки, однако это и не опровергается.

Information We Collect in Standard Mode. <…> Usage Information. To help us understand how you use our Services and to help us improve them, we automatically receive information about your interactions with our Services, like the pages or other content you view, and the dates and times of your visits. Private mode differs significantly from this as described above.

(«Информация, которую мы собираем в режиме Standard. <…> Информация об использовании. Чтобы понимать, как вы используете наши сервисы, и улучшать их, мы автоматически получаем информацию о вашем взаимодействии с нашими сервисами, например о том, какие страницы и другой контент вы просматриваете, в какие даты и в какое время вы пользуетесь нашими сервисами. Приватный режим значительно отличается, как описано выше»).

Поскольку собранные данные используются для улучшения сервиса, нельзя исключать и того, что на них обучаются модели. В разделе How We Use the Information We Collect in Standard mode («Как мы используем информацию, которую собираем в режиме Standard») также указано: To provide, maintain, improve, and enhance our Services («для предоставления, поддержки и улучшения наших сервисов»).

Genius от Alloy Studios тоже не дает однозначного ответа на вопрос о сборе затравок и использовании их для обучения моделей. В политике конфиденциальности используются стандартные формулировки без какой-либо конкретики по интересующему нас вопросу:

We collect certain information that your mobile device sends when you use our services <…> as well as information about your use of our services through your device.

(«Мы собираем определенную информацию, которую ваше мобильное устройство отправляет, когда вы пользуетесь нашими сервисами, а также информацию о том, как вы используете наши сервисы на своем устройстве»).

Такая формулировка может говорить о том, что сервис собирает тексты запросов к чат-боту, однако однозначно утверждать этого нельзя. По поводу использования информации, упомянутой выше, в политике конфиденциальности компании говорится следующее:

We use the information we collect to provide our services, to respond to inquiries, to personalize and improve our services and your experiences when you use our services.

(«Мы используем собранную информацию для предоставления наших сервисов, ответа на обращения, персонализации и улучшения наших сервисов и вашего опыта»).

В итоге, как мы увидели, решения для бизнеса в целом достаточно безопасны для использования. В сегменте B2B требования к безопасности и конфиденциальности выше, как и риски от утечки корпоративной информации. Как следствие, условия использования, сбора, хранения и обработки данных более серьезно нацелены на их защиту, чем в сегменте B2C. Рассмотренные B2B-решения не сохраняют историю общения по умолчанию, а в некоторых случаях затравки вообще не отправляются на серверы компании, предоставляющей сервис, поскольку чат-бот разворачивается локально в сети клиента.

Что же касается пользовательских чат-ботов, то они, к сожалению, не подходят для решения задач, в которых нельзя обойтись без анализа внутрикорпоративных или конфиденциальных данных. Некоторые из них позволяют выставить строгие настройки конфиденциальности или выбрать приватный режим, однако даже в этом случае присутствуют определенные риски. Например, сотрудник может забыть про настройки или случайно сбросить их. При этом возможности централизованно контролировать аккаунты пользователей в них не предусмотрено. Для работодателя выгоднее приобрести бизнес-решение, если в этом есть необходимость, чем пострадать от утечки конфиденциальной информации, когда сотрудники будут использовать чат-бота самостоятельно «под столом». А они будут.

Права пользователей в отношении персональных данных

Мы разобрались в том, какие инструменты даются пользователям для самостоятельной защиты от несанкционированного доступа к их данным, что можно сделать с историей общения с чат-ботом и действительно ли компании-разработчики тренируют свои модели на пользовательских данных. Теперь давайте поймем, какие права есть у пользователей в отношении информации, которую они предоставляют чат-боту.

Обычно такого рода сведения содержатся на странице политики конфиденциальности в разделе Your rights («Ваши права») или похожем. Анализируя этот раздел, стоит обратить внимание на его соответствие требованиям европейского регламента по защите данных (GDPR) о том, как должна преподноситься информация и какие права должны быть предоставлены пользователям (приводятся в главе 3). Даже если вы живете вне ЕС и GDPR вас не защищает, соответствие регламенту указывает на добросовестность сервиса.

Одно из основных требований GDPR к подаче информации о правах пользователя — это прозрачность, понятность и доступная форма описания. Сам список необходимых прав включает право на исправление, удаление и получение собранных персональных данных, а также на отказ от обработки личной информации. Право на удаление данных — одно из самых полезных в этом списке. В частности, оно может пригодиться, если пользователю больше не нужен этот сервис.

Практически все рассматриваемые нами компании приводят права пользователей в политике конфиденциальности в достаточно прозрачной и читаемой форме. У OpenAI эта информация размещена в пункте 4. Your rights («Ваши права»). Компания позволяет получать, удалять и исправлять данные, ограничивать их обработку и полностью отказываться от нее. У Claude (Anthropic) права пользователей описаны в пункте 5. Rights and Choices («Права и выбор»). В них входит право знать, какую информацию собирает компания, получать к ней доступ, исправлять, удалять и отказываться от предоставления данных. У Microsoft Bing Chat в разделе How to access and control your personal data («Как получить и контролировать ваши персональные данные») достаточно много информации о том, как и где можно исправить или удалить данные, но, к сожалению, четкого перечня прав пользователей в соответствии с GDPR нет. У Google на странице Privacy & Terms («Условия и конфиденциальность») в разделах Your privacy controls («Ваши настройки конфиденциальности») и Exporting and deleting your information («Выгрузка и удаление ваших данных») есть подробная инструкция как, где и что можно сделать со своими данными.

У You.com нет специального раздела с перечнем прав пользователя. Единственное место, где они хоть как-то упоминаются, находится в конце раздела How We Use the Information We Collect in Standard mode («Как мы используем информацию, которую собираем в режиме Standard»):

You are in control of your information:

You can unsubscribe from our promotional emails via the link provided in the emails. Even if you opt-out of receiving promotional messages from us, you will continue to receive administrative messages from us.

You can request the deletion of your user profile and all data associated to it by emailing us at legal@you.com.

(«Вы контролируете свою информацию:

Вы можете отписаться от нашей проморассылки при помощи ссылки в электронных письмах. Даже если вы откажетесь от получения рекламных писем, вы продолжите получать административные сообщения.

Вы можете запросить удаление вашего профиля пользователя и связанных с ним данных, отправив письмо на адрес legal@you.com».)

В политике конфиденциальности Genius нет вообще ни слова о правах пользователей.

Стоит отметить, что упоминание прав пользователей в политике приватности сервиса не гарантирует их соблюдение. Реальные возможности зависят от того, в чьей юрисдикции вы находитесь и как защищает ваши данные местное законодательство. Однако, как мы уже упоминали, соответствие таким стандартам, как GDPR, в любом случае указывает на добросовестный подход сервиса.

Заключение

Мы рассмотрели основные угрозы, которые связаны с использованием современных чат-ботов на основе больших языковых моделей для решения рабочих задач, и выяснили, что наиболее высок риск утечки конфиденциальных данных, если сотрудники используют персональные аккаунты на работе.

Это означает, что для компаний на первый план выходит повышение осведомленности персонала о рисках использования чат-ботов. С одной стороны, сотрудники должны понимать, какие данные являются конфиденциальными, составляют коммерческую тайну или относятся к персональной информации и почему их нельзя использовать в общении с чат-ботом. С другой — в компании должны быть четкие правила обращения с подобными сервисами, если они вообще разрешены. Наконец, не на последнем месте стоит и информированность о потенциальных фишинговых атаках, которые могут эксплуатировать популярность темы генеративного ИИ.

В идеальном случае, если компания видит преимущества в доступе персонала к разговорным интерфейсам, ей стоит использовать решения для бизнеса с понятным механизмом хранения данных и возможностью централизованного управления. Если отдать выбор чат-ботов и защиту аккаунтов на откуп сотрудникам, то из-за большой разницы в политиках конфиденциальности и настройках аккаунтов можно в итоге столкнуться с утечкой данных. Чтобы исключить сценарий, когда работники по собственной инициативе обращаются к ненадежному чат-боту в рабочих целях, можно воспользоваться защитным решением с функцией анализа облачных сервисов. В нашем решении Kaspersky Endpoint Security Cloud есть опция Cloud Discovery, позволяющая управлять облачными сервисами и оценивать риски, связанные с их использованием.

ChatGPT на работе: как чат-боты помогают сотрудникам, но угрожают бизнесу